A medida que la industria de la seguridad ha mejorado en el reconocimiento de las señales que deben convertirse en alertas, el campanazo con su "ding" metálico u otra alerta que exige atención puede ser casi traumático para un analista de seguridad cansado. Cada una de estas alertas tiene el potencial de ser la primera señal de un incidente de seguridad importante, pero relativamente pocas lo son.

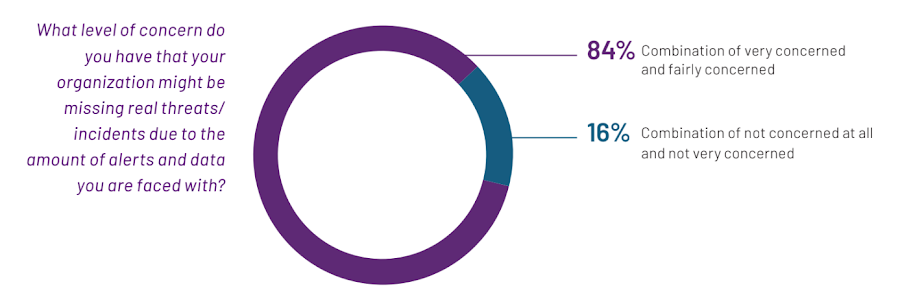

La fatiga de alertas hace que sea más difícil distinguir las amenazas más graves de las amenazas menores y los falsos positivos. Según la encuesta Global Perspectives on Threat Intelligence de 2023 de Mandiant, el 84 % de los encuestados dijeron que están "bastante preocupados" o "muy preocupados" de que su organización pueda estar pasando por alto amenazas o incidentes reales debido al volumen de alertas y datos que deben responder. y analizar.

En la misma encuesta, el 69% de los encuestados dijeron que creen que sus empleados de TI "se sienten abrumados" por las alertas y los datos entrantes. Esa cifra saltó al 84% para los encuestados de América del Norte, cuando se desglosó por región.

La mayoría de los encuestados dijeron que están "bastante preocupados" o "muy preocupados" de que su organización pueda estar pasando por alto amenazas o incidentes reales debido al volumen de alertas y datos a los que deben responder y analizar, 2023 Global Perspectives on Threat Intelligence, Mandiant .

La fatiga de alertas ha sido durante mucho tiempo una lucha en la ciberseguridad y parte de un problema mayor que llamamos "sobrecarga de amenazas". Este desafío, junto con la naturaleza manual de la mayoría de las tareas de operaciones de seguridad que genera un gran esfuerzo humano y la creciente brecha de talento en seguridad, es conocido por agotar los equipos de seguridad y por impedir que los centros de operaciones de seguridad puedan optimizar su trabajo y pasar de siendo en gran medida reactivos a más proactivos.

Hablando directamente con los miembros de la junta, los líderes empresariales, los CIO, los CISO y los principales profesionales de seguridad, los expertos en seguridad de Google Cloud y Mandiant siempre han escuchado lo mismo: existe una necesidad urgente de tecnología para simplificar problemas complejos para aquellos con menos experiencia en seguridad. y proporcionar orientación sobre la mejor manera de actuar. Creemos que las herramientas de aprendizaje automático (ML) e inteligencia artificial (IA) pueden aligerar significativamente la carga, y posiblemente incluso eliminar, tres de los problemas más espinosos de la seguridad.

Obtenga actualizaciones de seguridad, reflexiones y más del CISO de Google Cloud, Phil Venables

Marchito por el trabajo

Dos de esos problemas espinosos, el exceso de amenazas y la falta de expertos capacitados para abordarlos, son problemas difíciles de resolver, pero no necesariamente complicados. Sin embargo, el "trabajo duro" es un cepellón desordenado que puede estrangular los esfuerzos incluso de las organizaciones con mejores recursos.

Las operaciones de seguridad han estado atrapadas durante mucho tiempo en las garras del trabajo duro. Tal como se define en el libro Site Reliability Engineering de Google, el trabajo duro es "el tipo de trabajo relacionado con la ejecución de un servicio de producción que tiende a ser manual, repetitivo, automatizable, táctico, sin valor duradero y que escala linealmente a medida que crece el servicio".

Para algunos analistas, toda su carga de trabajo se ajusta a la definición de "trabajo duro" de la SRE.

Iman Ghanizada, director global de Autonomic Security Operations, Google Cloud, y Anton Chuvakin, estratega de soluciones de seguridad, Google Cloud

El trabajo duro también puede sofocar a los expertos en seguridad calificados antes de que hayan tenido la oportunidad de convertirse en el tipo de ingenieros dedicados que pueden ayudar a cerrar la brecha de talento, escribieron Iman Ghanizada, director global de Operaciones de Seguridad Autonómica de Google Cloud, y Anton Chuvakin, estratega de soluciones de seguridad. .

“Si es un analista de seguridad, puede darse cuenta de que analizar el trabajo duro es uno de los elementos más importantes y gravosos de su función”, escribieron. "Para algunos analistas, toda su carga de trabajo se ajusta a la definición de SRE de 'trabajo duro'".

Los líderes de seguridad nos dicen que las herramientas son uno de los mayores productores de trabajo, por lo que parte de la misión de Google Cloud es aprovechar la IA de manera que permita a los equipos usar mejor las herramientas que tienen y, en algunos casos, deshacerse de ellas por completo. La IA puede ayudar a resolver estos problemas apoyando a los equipos en la gestión de múltiples entornos, implementando el diseño y las capacidades de seguridad y generando controles de seguridad, ayudando de manera efectiva a los sistemas a protegerse a sí mismos.

Enfrentando el enjambre de amenazas

En la parte superior de la publicación, hablamos sobre la fatiga de alertas como parte de un problema mayor: la sobrecarga de amenazas. La sobrecarga de amenazas es la idea de que hay demasiadas amenazas y las organizaciones no pueden rastrearlas todas. Tampoco deberían intentarlo. Una de las mejores opciones para liberar recursos y hacer que las operaciones de seguridad sean más eficientes ha sido usar inteligencia de amenazas para identificar y proteger el negocio contra las amenazas más importantes.

Cuando una organización ingiere información sobre amenazas y busca vulnerabilidades, es importante poder priorizar las respuestas. La inteligencia solo es útil si una organización puede aplicarla correctamente, y muchas organizaciones luchan por hacerlo. La IA puede ayudar a identificar las vulnerabilidades de una organización, si los actores de amenazas están explotando esas vulnerabilidades para atacar a las organizaciones y cuál es la mejor manera de priorizar la respuesta defensiva de la organización. En última instancia, la IA puede ayudar a reducir la exposición de una organización y evitar que los incidentes se conviertan potencialmente en infracciones en toda regla.

Cuidado con la brecha de talento

Aunque las organizaciones a menudo buscarán tecnología y automatización para resolver problemas de ciberseguridad, todavía hay un componente humano en la seguridad. Sin embargo, encontrar personas con las habilidades adecuadas para realizar esos trabajos es un desafío, y parece volverse más complejo a medida que la superficie de ataque y, posteriormente, el panorama de amenazas continúa evolucionando.

Debido a que la demanda de trabajadores calificados en seguridad cibernética es tan alta, las organizaciones a menudo no tienen el presupuesto, las herramientas tecnológicas de seguridad o la madurez institucional para adquirirlos. Además, muchos trabajadores calificados en seguridad cibernética no quieren lidiar con la alta presión y los factores estresantes que conlleva trabajar en organizaciones menos expertas en seguridad.

El uso de la IA de esta manera puede ayudar a cerrar la brecha de habilidades y ampliar el grupo de contratación, ya que la IA debería poder dar sentido a los problemas complejos e interpretar los resultados para el personal con menos habilidades técnicas.

Si bien hay esfuerzos para capacitar a más expertos, especialmente aquellos con antecedentes más diversos, para los equipos de seguridad, la adopción de tecnologías integradas de IA y ML para automatizar tareas mundanas y repetitivas puede ayudar a llenar los vacíos de contratación en los centros de operaciones de seguridad con recursos limitados.

Por ejemplo, la IA generativa puede ayudar a emparejar a los analistas con modelos de lenguaje extenso (LLM) específicos de seguridad que pueden completar tareas arduas a una velocidad vertiginosa y luego convertir ese trabajo en tareas procesables. El uso de la IA de esta manera puede ayudar a cerrar la brecha de habilidades y ampliar el grupo de contratación, ya que la IA debería poder dar sentido a los problemas complejos e interpretar los resultados para el personal con menos habilidades técnicas.

La IA en seguridad ya está aquí y sigue creciendo

Ya hemos estado usando IA para ayudar a los equipos de seguridad a reducir la fatiga de las alertas, respaldar el análisis de malware, mejorar la eficiencia del centro de operaciones de seguridad y, en última instancia, hacer más con menos. La IA generativa puede dar un salto más allá de cómo aplicamos la IA y el ML en la actualidad.

Los avances recientes, incluidos los LLM y otras tecnologías de IA generativa, respaldarán aún más los esfuerzos para mejorar la seguridad en la industria de TI, en particular al aprovechar la inteligencia de primera línea para ayudar a las organizaciones a combatir las amenazas más importantes. Si bien la IA no es una bala de plata inmediata para los mayores dolores de la seguridad, las posibilidades de la IA y la seguridad, y especialmente en torno a los LLM centrados en la seguridad, como Security AI Workbench que anunciamos esta semana en la Conferencia RSA, crean casos de uso poderosos y oportunidades expansivas. sobre cómo la IA puede ayudar a los equipos de seguridad a ser aún más efectivos. --

Seth Rosenblatt

Security Editor, Google Cloud